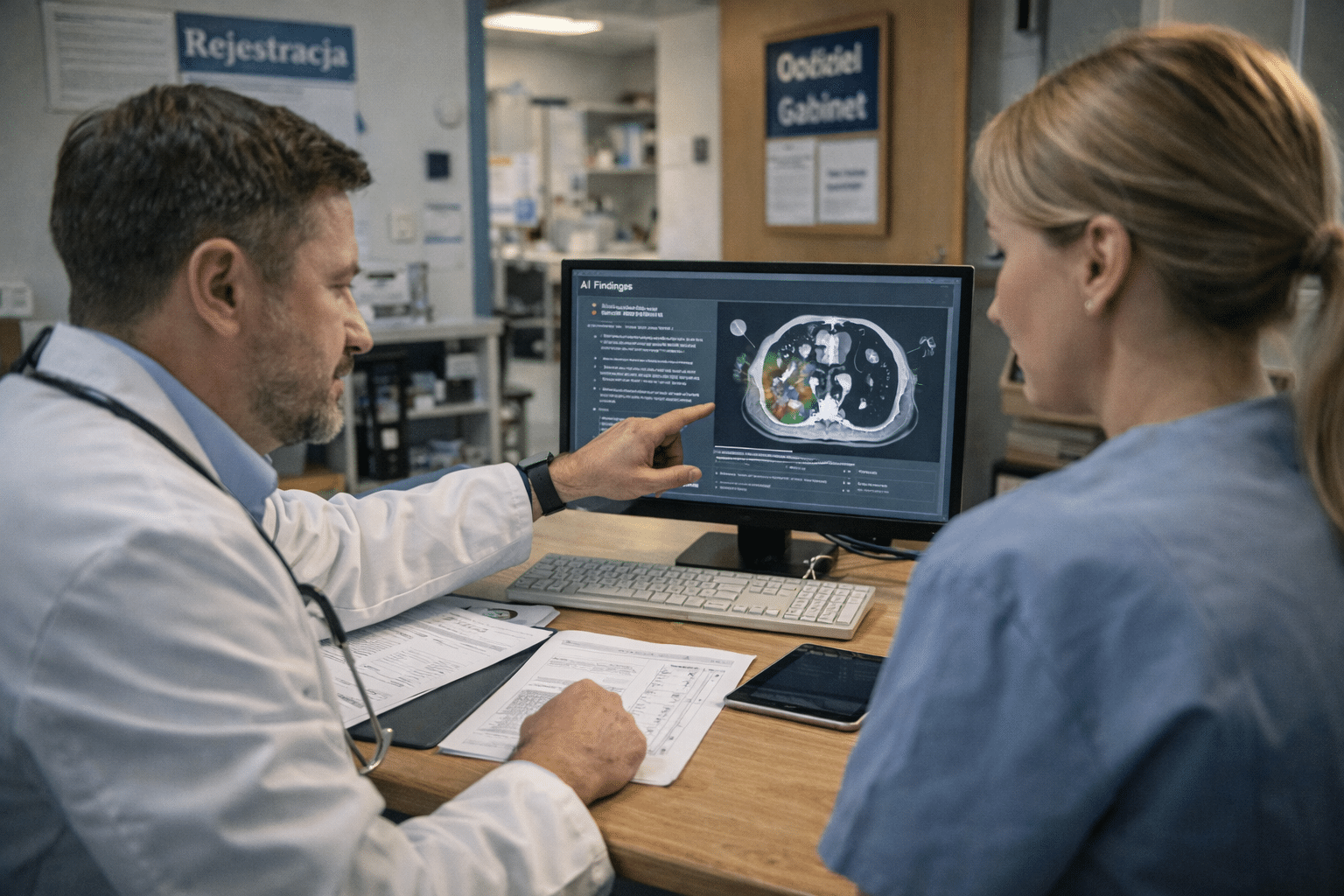

AI w medycynie nie jest już „futurystycznym gadżetem”. To triage na SOR, analiza zdjęć RTG, wsparcie decyzji klinicznych, systemy przewidujące ryzyko powikłań, a czasem także element wyrobu medycznego (np. oprogramowanie, które „podpowiada” rozpoznanie).

I tu pojawia się pytanie, które wraca w kancelariach coraz częściej: kto odpowiada, jeśli AI doprowadziło do szkody pacjenta? Lekarz? Szpital? Producent? A może każdy po trochu – zależnie od tego, co dokładnie się wydarzyło.

Jeśli interesują Cię klasyczne sprawy o błędy medyczne (bez wątku AI), zobacz też:

Odszkodowanie za błąd medyczny.

Spis treści:

- Kiedy AI robi się problemem prawnym

- Kto może odpowiadać za szkodę: mapa odpowiedzialności

- Odpowiedzialność lekarza: „AI powiedziała” to nie tarcza

- Odpowiedzialność szpitala/podmiotu leczniczego: organizacja, procedury, nadzór

- Odpowiedzialność producenta: gdy AI jest wyrobem medycznym albo jego częścią

- Dowody w sprawie z AI: co zbierać, zanim zniknie

- Checklista: 10 pytań, które przesądzają o kierunku sprawy

- FAQ

Kiedy AI robi się problemem prawnym

Nie każda „pomoc” algorytmu tworzy nową odpowiedzialność. Zwykle robi się poważnie, gdy:

- AI wpływa na decyzję medyczną (diagnoza, kwalifikacja do zabiegu, dobór terapii, wypis),

- AI zastępuje człowieka w newralgicznym etapie (np. automatyczna klasyfikacja wyniku bez realnej weryfikacji),

- system jest „czarną skrzynką” i nie wiadomo, dlaczego podjął daną decyzję,

- szpital wdrożył narzędzie bez procedur: brak szkolenia, brak zasad weryfikacji, brak odpowiedzialnego nadzoru.

Kto może odpowiadać za szkodę: mapa odpowiedzialności

W praktyce spór rzadko jest „zero-jedynkowy”. Najczęściej w grze są co najmniej trzy poziomy:

1) Człowiek (lekarz / personel)

To odpowiedzialność za własne działania i zaniechania: czy decyzja była staranna, czy wynik AI został zweryfikowany, czy nie zignorowano czerwonych flag.

2) Podmiot leczniczy (szpital / przychodnia)

To odpowiedzialność za organizację: wdrożenie, procedury, szkolenia, dobór narzędzia, nadzór nad użyciem, bezpieczeństwo danych i dokumentacji.

3) Producent / dostawca technologii

To odpowiedzialność za produkt/oprogramowanie: wady, błędy projektowe, niebezpieczne działanie, braki w instrukcji, aktualizacjach, ostrzeżeniach i ograniczeniach zastosowania.

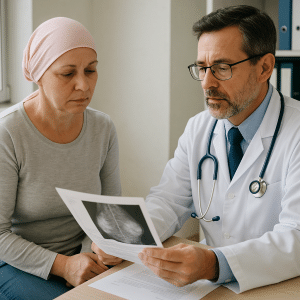

Odpowiedzialność lekarza: „AI powiedziała” to nie tarcza

Najprostsza zasada, którą warto zapamiętać: AI nie jest „trzecim lekarzem”, na którego można przerzucić winę.

Jeżeli system jest narzędziem wspierającym decyzję, lekarz nadal odpowiada za to, czy:

- zebrał prawidłowy wywiad i wykonał konieczne badania (a nie tylko „podpiął dane do algorytmu”),

- porównał wynik AI z obrazem klinicznym,

- zauważył, że AI działa poza zakresem (np. pacjent nie pasuje do populacji, na której system był uczony),

- nie potraktował wyniku jako „wyroku”, gdy były przesłanki do weryfikacji.

W praktyce procesowej lekarza „boli” zwykle nie to, że użył AI, tylko to, że użył jej bezmyślnie albo bez procedury.

Odpowiedzialność szpitala/podmiotu leczniczego: organizacja, procedury, nadzór

Jeżeli AI jest wdrożona „systemowo”, podmiot leczniczy nie ucieknie od pytań:

- kto podjął decyzję o wdrożeniu i na jakiej podstawie (analiza ryzyka, testy, walidacja),

- czy personel był przeszkolony i czy są instrukcje użycia (także ograniczenia),

- czy są zasady: kiedy wynik AI wolno stosować, a kiedy wymagana jest dodatkowa konsultacja,

- czy system był aktualizowany i czy kontrolowano „dryf” (spadek jakości w czasie),

- czy jest ścieżka reagowania na incydenty (błąd systemu, nieprawidłowe rekomendacje, zgłoszenia personelu).

To jest ten moment, w którym sprawa z „błędu pojedynczego lekarza” zmienia się w sprawę o zaniedbania organizacyjne.

Odpowiedzialność producenta: gdy AI jest wyrobem medycznym albo jego częścią

W części spraw AI w medycynie to po prostu oprogramowanie medyczne (czasem klasyfikowane jako wyrób medyczny), które ma wymagania bezpieczeństwa i zgodności. Wtedy rośnie znaczenie odpowiedzialności „produktowej”:

- czy produkt był bezpieczny przy normalnym użyciu,

- czy miał jasne ostrzeżenia i ograniczenia (kiedy nie wolno go stosować),

- czy błąd wynikał z wady systemu (np. znany problem w określonym typie badania),

- czy aktualizacje były wdrażane i komunikowane,

- czy integracja (np. z systemem szpitalnym) nie powodowała błędów w danych wejściowych.

Uwaga praktyczna: w sporach z producentem kluczowe jest odtworzenie tego, co dokładnie system „widział” (dane wejściowe), co wygenerował (wynik, rekomendacja) i w jakiej wersji działał.

Dowody w sprawie z AI: co zbierać, zanim zniknie

Wątek AI ma jedną wspólną cechę: dowody potrafią „wyparować”, jeśli nikt ich od razu nie zabezpieczy. Co warto zebrać (lub zażądać zabezpieczenia) możliwie szybko:

- pełna dokumentacja medyczna (historia choroby, zlecenia, wyniki, opisy badań),

- wydruki/raporty z systemu (wynik AI, rekomendacje, alerty),

- informacja o wersji systemu i konfiguracji (to robi różnicę),

- logi: kto i kiedy uruchomił analizę, jakie dane wprowadzono, co system zwrócił,

- procedury szpitala: instrukcja użycia, szkolenia, zasady weryfikacji wyniku,

- korespondencja/incydenty: zgłoszenia personelu, komunikaty o błędach, aktualizacjach.

Jeżeli sprawa idzie w spór, często decyduje nie „czy AI się pomyliła”, tylko czy da się to udowodnić technicznie.

Checklista: 10 pytań, które przesądzają o kierunku sprawy

- Czy AI była tylko „podpowiedzią”, czy realnie zastąpiła weryfikację?

- Czy lekarz miał podstawy, by wynik zakwestionować (objawy, badania, alarmy)?

- Czy pacjent „pasował” do zastosowania narzędzia (wiek, choroby, typ badania)?

- Czy narzędzie miało jasno opisane ograniczenia i czy były znane personelowi?

- Czy szpital miał procedurę: kiedy wynik AI wymaga konsultacji / dodatkowej diagnostyki?

- Czy doszło do błędu danych wejściowych (zły plik, zła jakość obrazu, pomyłka w integracji)?

- Jaka wersja systemu działała w dacie zdarzenia?

- Czy są logi lub raporty potwierdzające, co system wygenerował?

- Jaki jest łańcuch przyczynowy: AI → decyzja → szkoda?

- Co jest najbardziej prawdopodobne: błąd człowieka, błąd organizacji czy wada produktu?

FAQ

Czy lekarz zawsze odpowiada, jeśli używał AI?

Nie „z automatu”. Ale nie może też zasłonić się AI. Jeśli wynik był sprzeczny z obrazem klinicznym, a mimo to zrobiono „po algorytmie”, odpowiedzialność lekarza wraca na stół.

Czy szpital może odpowiadać za źle wdrożoną AI?

Tak – szczególnie gdy brakuje procedur, szkoleń, nadzoru, a system w praktyce zastępuje weryfikację medyczną albo działa poza kontrolą jakości.

Czy producent może odpowiadać za błąd algorytmu?

Może, jeśli szkoda wynika z wady produktu/oprogramowania albo z braku właściwych ostrzeżeń, instrukcji i ograniczeń użycia. W takich sprawach kluczowe są dane techniczne, wersje i logi.